IA générative & data governance : comment éviter la fuite de valeur ?

La promesse de l’IA générative est immense : productivité accrue, automatisation des tâches, amélioration des interactions client, accélération de l’innovation. Pourtant, à mesure que ces modèles se déploient dans les entreprises, un risque majeur émerge : la fuite de valeur due à une gouvernance des données insuffisante ou mal alignée avec les usages IA.

Dans un contexte où les données sont le carburant de ces nouveaux systèmes, une gouvernance solide et dynamique est une condition pour transformer l’expérimentation en valeur durable. Et désormais, au-delà de la data governance, il est essentiel d’élargir le périmètre vers une gouvernance IA – un cadre qui englobe à la fois les données, les modèles, les usages et les risques associés.

1. Comprendre le nouveau risque : où se perd la valeur dans l’IA générative ?

Les projets d’IA générative mobilisent une diversité de données textuelles, structurées, voire multimodales. Dans cette complexité, plusieurs facteurs peuvent entraîner des pertes de valeur :

- Fuites de données sensibles (prompt injection, mauvaises configurations des LLMs, accès non contrôlés)

- Hallucinations des modèles : une mauvaise qualité des données d’entrée ou un fine-tuning biaisé génèrent des réponses incorrectes, voire risquées

- Shadow AI : des usages non encadrés par les métiers ou IT, échappant à toute stratégie de gouvernance

- Manque de traçabilité : impossibilité d’expliquer ou de reproduire les outputs des modèles génératifs, rendant le pilotage impossible

- Absence de documentation ou d’audibilité : les processus d’IA sont souvent peu ou mal documentés, rendant leur évaluation difficile

- Notations sociales ou catégorisations biométriques : des biais implicites ou explicites peuvent être introduits dans les outputs des modèles, créant des risques éthiques et réglementaires majeurs

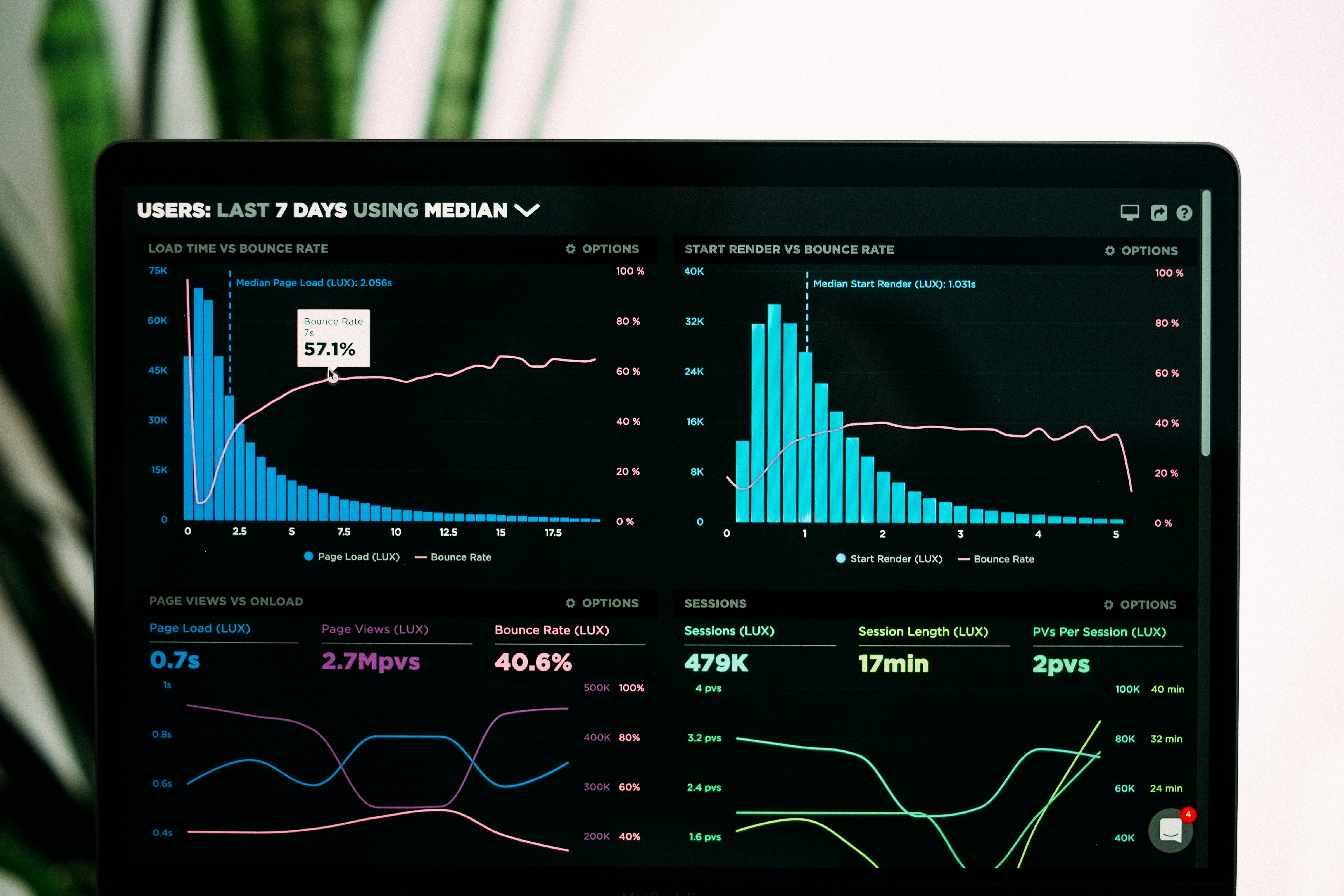

🔍 Quelques chiffres clés pour mesurer l’ampleur du phénomène :

- 97 % des organisations ont subi des incidents de sécurité liés à l’IA générative en un an

- 43 % des entreprises déclarent des pertes directes dues à des deepfakes ou contenus malveillants

- 39 % des organisations dotées de restrictions sur l’IA observent des violations régulières de leurs règles

- Les données de mauvaise qualité coûtent jusqu’à 6 % du chiffre d’affaires annuel

Résultat : des modèles coûteux à entraîner ou à intégrer, dont la valeur ne se traduit pas toujours en gains métiers mesurables.

2. Ce que l’IA générative change concrètement pour la gouvernance

La gouvernance classique ne suffit plus. L’arrivée de l’IA générative impose une extension des règles et des responsabilités, articulée autour de trois piliers :

a. Gouverner les prompts et les contextes

L’input devient aussi stratégique que le modèle lui-même. Il est donc crucial de :

- Standardiser les prompts métier

- Éviter les fuites de données sensibles dans les contextes injectés

- Évaluer et documenter la provenance des données utilisées dans le fine-tuning ou le RAG

b. Évaluer la qualité des sorties générées

La gouvernance doit intégrer une nouvelle métrique : la qualité des réponses générées. Cela implique de :

- Mettre en place des systèmes d’évaluation automatisés

- Définir des critères métiers de pertinence et de conformité

- Tracer l’usage des sorties générées (dans un workflow, une prise de décision, etc.)

c. Appliquer une gouvernance dynamique et itérative

L’IA générative évolue rapidement. La gouvernance doit être agile, contextualisée et itérative :

- Gouvernance centrée produit : des règles qui évoluent avec les cas d’usage

- Collaboration étroite entre data governance, data science et métiers

- Mise en place de feedback loops pour ajuster prompts, sources de données et comportements des modèles

3. Les leviers opérationnels pour éviter la fuite de valeur

Voici quelques actions concrètes à mettre en place pour sécuriser et maximiser la valeur des projets IA générative :

- Cartographier les données utilisées (input/output) → Identifier les risques de fuite ou de non-conformité

- Mettre en place des outils de gestion des prompts (prompt management) → Structurer, historiser et auditer les interactions IA

- Intégrer des mécanismes de contrôle dans les workflows métiers → Filtrer, valider ou enrichir les réponses générées

- Tracer les performances des modèles dans le temps → Mesurer la valeur réelle apportée aux métiers

- Formaliser une politique d’usage responsable de l’IA → Aligner juridique, sécurité, innovation et éthique

- Suivre les guidelines de l’AI Act → Par exemple, mettre en place une matrice de risques IA (Critique, Haut, Limité, Négligeable)

- Organiser des sessions de contrôle à chaque étape du cycle IA → Architecture, documentation, sécurité, depuis la demande métier jusqu’à la mise en production

💡 Ces actions peuvent également ouvrir la voie à un futur article dédié à la mise en conformité AI Act, un chantier à anticiper dès maintenant.

4. Gouverner, c’est libérer le potentiel de l’IA

Chez Esmoz, nous sommes convaincus que la gouvernance n’est pas une contrainte, mais un levier de performance durable. Elle permet de créer un socle robuste pour :

- Industrialiser l’IA générative

- Fiabiliser les cas d’usage

- Réduire les risques de réputation, de conformité ou de duplication d’effort

- Assurer un retour sur investissement mesurable

L’IA générative ne sera pas durable sans une gouvernance moderne, intégrée, et désormais, hybride entre data et IA. Ce n’est qu’en traitant les données et les modèles comme des actifs stratégiques — du prompt jusqu’au résultat généré — que l’on peut véritablement éviter la fuite de valeur.

Vous développez un projet IA générative et souhaitez en maximiser la valeur ?

Esmoz vous accompagne pour construire une gouvernance IA sur-mesure, adaptée à vos enjeux métiers, IT et réglementaires.