Les enjeux majeurs de la Data Quality

Dans un monde de plus en plus orienté vers la data, les organisations accumulent des quantités massives de données. Bien que ces informations soient des ressources précieuses pour la prise de décision, leur gestion efficace est devenue plus complexe et cruciale.

L’une des pratiques essentielles dans ce contexte est l’amélioration de la Data Quality (qualité des données). Ce processus est devenu un impératif stratégique face aux pressions réglementaires et environnementales croissantes. La Data Quality ne se limite plus à une simple étape dans la gestion des données, elle représente désormais un facteur clé de succès pour les entreprises.

Le contexte des réglementations et des exigences environnementales

Les nouvelles législations sur la protection des données, telles que le RGPD (Règlement Général sur la Protection des Données) en Europe ou le CCPA (California Consumer Privacy Act) aux États-Unis, imposent aux entreprises de maîtriser l’intégralité du cycle de vie de leurs données. Ignorer les données inutiles ou obsolètes expose les organisations à des sanctions financières et à des dommages réputationnels.

Par ailleurs, dans une optique de durabilité, les entreprises doivent repenser leur impact environnemental. L’accumulation massive de données inutilisées (data hoarding) n’est plus tenable d’un point de vue énergétique, surtout lorsqu’on sait que le stockage de ces données consomme des ressources considérables, tant dans les data centers que dans le cloud.

Pourquoi la Data Quality devient essentielle ?

Conformité réglementaire et gestion du cycle de vie des données

La Data Quality permet de garantir que les données stockées sont pertinentes, à jour et conformes aux réglementations en vigueur. Les entreprises doivent veiller à ce que les informations sensibles ou périmées soient supprimées dans les délais impartis pour éviter tout manquement aux lois sur la protection des données.

Réduction de l’empreinte carbone des organisations

Selon certaines études, l’empreinte carbone des infrastructures numériques pourrait représenter jusqu’à 3,7 % des émissions mondiales de gaz à effet de serre. L’amélioration de la Data Quality réduit la quantité de données stockées, optimisant ainsi l’utilisation des ressources de calcul et réduisant la consommation énergétique.

Dans un monde où chaque kilo de CO2 compte, une gestion rigoureuse des données devient un facteur environnemental crucial.

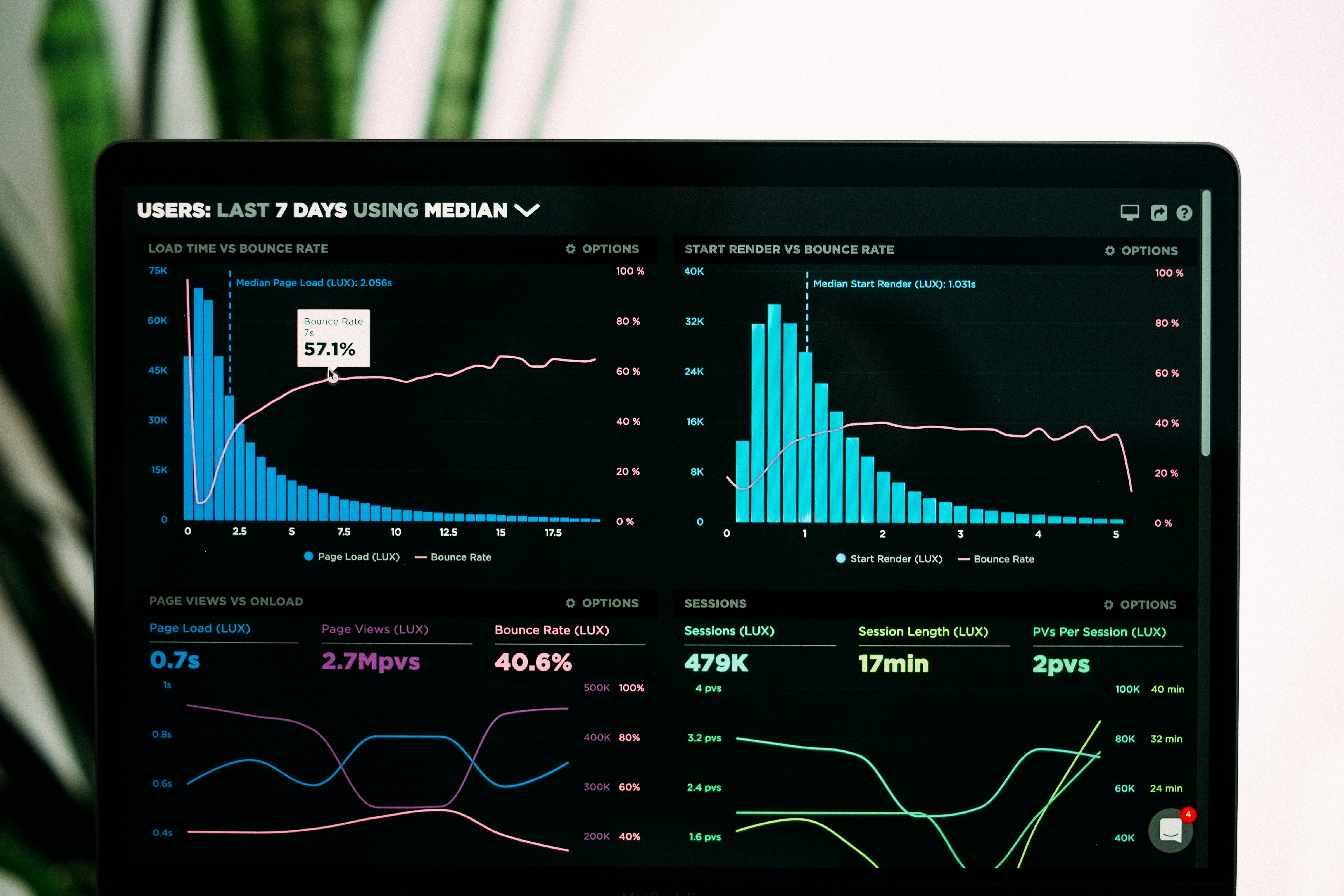

Amélioration des performances des systèmes d’analyse

Des données mal structurées et de mauvaise qualité peuvent nuire à la performance des algorithmes d’IA, des systèmes d’analytics et des modèles prédictifs. Une Data Quality rigoureuse garantit l’intégrité et la fiabilité des données, améliorant ainsi la précision des résultats et réduisant les erreurs.

Optimisation des coûts de stockage

Bien que les coûts de stockage aient diminué avec l’avènement du cloud, ils restent un facteur économique important. En ne conservant que les données propres et nécessaires, les organisations optimisent l’utilisation des ressources et réduisent les coûts liés à l’espace de stockage.

Vers une automatisation intelligente de la Data Quality

Historiquement, améliorer la qualité des données était perçu comme une tâche manuelle et fastidieuse. Cependant, des innovations dans l’automatisation changent la donne. Les outils de Data Governance, couplés à des techniques avancées d’intelligence artificielle et de machine learning, permettent de détecter automatiquement les anomalies, doublons et autres incohérences dans les datasets.

L’automatisation intelligente de la Data Quality libère les équipes de data engineers de tâches chronophages tout en garantissant des résultats plus rapides et précis.

Les limites des méthodes traditionnelles de gestion de la Data Quality

La gestion manuelle de la Data Quality repose sur une série d’étapes répétitives, telles que :

L’identification et la suppression des doublons ;

La gestion des valeurs manquantes ;

La correction des incohérences dans les formats de données ;

La vérification de l’exactitude des valeurs selon les règles métiers.

Cette méthode présente cependant plusieurs inconvénients :

Erreurs humaines ;

Coûts élevés en temps et en ressources ;

Incapacité à suivre le rythme croissant des données.

L’émergence des outils d’automatisation intelligente

L’automatisation intelligente se distingue par sa capacité à apprendre et à s’adapter aux particularités des datasets en utilisant le machine learning (ML) et l’intelligence artificielle (IA). Elle permet de détecter, corriger et nettoyer les données avec une efficacité accrue.

Technologies clés associées à cette approche :

Apprentissage supervisé et non supervisé : Ces techniques permettent de former des modèles sur des datasets propres pour ensuite les appliquer à de nouvelles données et détecter les anomalies ou duplications.

Algorithmes de clustering : Utilisés pour regrouper des données similaires, ils aident à identifier automatiquement les anomalies ou doublons dans les grands datasets.

Règles de gestion des données dynamiques : Ces systèmes ajustent les règles de nettoyage en fonction des nouvelles données.

Traitement automatique des données manquantes : Les modèles de ML imputent les valeurs manquantes au lieu de simplement les supprimer.

Les avantages concrets de l’automatisation de la Data Quality

Efficacité accrue : Les systèmes automatisés peuvent traiter d’énormes volumes de données en une fraction du temps nécessaire à une équipe humaine.

Amélioration continue : Grâce au machine learning, les systèmes de gestion de la Data Quality deviennent plus performants à mesure qu’ils traitent de nouveaux jeux de données.

Réduction des coûts : L’automatisation libère les data engineers des tâches répétitives, leur permettant de se concentrer sur des activités à plus forte valeur ajoutée.

Qualité des données : En utilisant des modèles intelligents, les entreprises réduisent les erreurs humaines et assurent une meilleure intégrité des données.

Les défis de l’automatisation de la Data Quality

Malgré ses avantages, l’automatisation intelligente de la Data Quality présente certains défis :

Qualité des algorithmes de ML : Les modèles nécessitent des données d’entraînement précises. Si les données de base sont biaisées, les résultats le seront aussi.

Biais algorithmiques : Les algorithmes risquent de perpétuer des biais s’ils sont mal entraînés.

Adaptation aux besoins spécifiques : Chaque entreprise a des règles de gestion de données différentes, et l’automatisation nécessite parfois une personnalisation poussée.

Perspectives futures

Automatisation sans code : De plus en plus d’outils sont conçus pour être accessibles aux équipes métiers sans compétences techniques avancées.

Nettoyage en temps réel : L’objectif est de nettoyer les données dès leur ingestion, permettant ainsi aux entreprises de prendre des décisions basées sur des données de qualité en temps réel.

Intégration avec les plateformes cloud : Les solutions cloud-native comme AWS Glue et Azure Data Factory intègrent des capacités d’automatisation de la Data Quality dans les pipelines de gestion des données.

Conclusion

En conclusion, la Data Quality s’impose comme un enjeu stratégique dans un contexte de transformation numérique sous contraintes réglementaires et environnementales. Assurer une Data Quality optimale permet non seulement de garantir la conformité, mais aussi d’optimiser les performances, de réduire les coûts et de limiter l’impact environnemental des entreprises.